Cool retweeted

前段塔勒布在告诉人们:

打工是件超高风险的事,小概率事件来临后,打工仔有灭顶之灾。

这还是在延续黑天鹅这本书关于概率的解释。

普通人认为的小概率是致命的。

我曾跟国产电车爱好者解释这个,他们没听懂。

电车燃烧是小概率,小于油车,但你死亡的概率是油车燃烧的几百倍。

开电车是很爽,一旦燃烧,死亡的风险无法用人生覆盖。

年轻人听不懂,嘲笑我这个期货老登。

这就像我说加密货币平台插针会让你倾家荡产,你赢一万次,赢一万倍,死于一毫秒。

他们也听不懂。

我用了三年才真正看懂《反脆弱》。

第一次读的时候,觉得塔勒布在卖弄——

一个交易员写这么厚一本书讲哲学,还动不动骂经济学家和银行家。

但三年后再翻,我发现他说的每一句话都是对的,只是我当时没资格懂。

这本书最狠辣的地方,是它揭穿了现代生活最大的谎言:稳定。

我们被教育要追求稳定——稳定的工作、稳定的收入、稳定的关系、稳定的人生规划。

整个社会都在贩卖这个幻觉:只要你足够努力,就能得到一份“稳定”的生活。

但塔勒布说,这是在自杀。

因为真实世界不是线性的。

你以为躲开了小波动,积累的能量会在某一天以黑天鹅的形式爆发。

2008年,那些在大银行工作的人,以为自己端着铁饭碗,结果一夜之间全部失业。

那些一辈子没生过病的人,一场大病就垮了。

那些从不吵架的夫妻,离婚时最决绝。

为什么?

因为他们从来没有接受过小的压力测试,失去了自我修复的能力。

塔勒布举了个例子我一直记得。

如果你给一个包裹贴上“易碎品”的标签,你是在乞求搬运工小心翼翼地对待它。

但现实是,没有人会真的小心。

这个包裹迟早会被摔。

真正的解决方案,不是乞求别人小心,而是让包裹本身能扛摔,甚至摔了之后变得更结实。

这就是——反脆弱。

而且塔勒布书里还有一个观点震撼了我:大部分的创新不是来自规划,而是来自试错。

我们以为是科学家在实验室里发明了技术,然后工程师拿去应用。

但历史的真相是反过来的——工匠在瞎搞的过程中发现了有用的东西,然后科学家写论文解释它为什么有用。

蒸汽机不是牛顿力学的产物,是工匠修修补补搞出来的。

飞机不是空气动力学的产物,是莱特兄弟摔了几百次摔出来的。

但我们的教育系统、公司管理、职业规划,全都建立在一个错误的假设上:

你要先想清楚再去做,你要有完美的计划,你要能预测结果。

这种思维最致命的地方是——它剥夺了你试错的权利。

它让你觉得失败是可耻的,是说明你没想清楚。

所以大家都不敢动,都在等一个“完美的时机”。

但塔勒布说,反脆弱系统的特征,就是大量的小试错。

每一次小失败都在给系统提供信息,让它知道什么不该做。

只要你控制好每次试错的成本,让它不至于毁掉你,那么随着试错次数的增加,你遇到大机会的概率就在不断上升。

这彻底改变了我对失败的看法。

以前我怕失败,因为觉得失败意味着我不行。

现在我知道,只要我控制好风险敞口,失败就是在给我反馈。

它在告诉我什么不该做,同时在缩小未知的范围。

只要每次失败的成本是可控的,那么失败得越多,我离成功就越近。

这才是反脆弱——不是不失败,而是让每一次失败都让你变得更强。

真实的成长曲线,不是斜向上的直线,而是长期平缓然后突然爆发。

我玩推特两个月,前七周每天发内容,涨粉慢得让人怀疑人生。

我在做各种尝试:德国留学就业分享、编程科普、语言学习技巧、生活碎片。

每条只有几个赞,每天涨粉个位数。

但我不知道哪个方向是对的,只能不断试错。

直到第八周,我发了一条读书笔记,突然爆了。

一周涨的粉丝,是之前七周的十倍以上。

那一刻我才明白——不是我的留学经历不够精彩,不是我的编程知识不够硬核,而是大家喜欢我写读书笔记的那种文风。

那种直白、有观点、不端着的表达方式。

如果我在第六周因为“看不到成效”放弃了,就永远不会发现这一点。

如果我一开始就笃定“我要做留学博主”,就不会尝试读书笔记这个方向。

这就是塔勒布说的——可选择性。

前七周看起来在乱试,其实是在积累选择权。

每一次小失败都在告诉我什么不行,同时在缩小搜索范围。

而那个突然爆发的第八周,不是运气,是大量试错之后,终于碰到了那个非线性的爆发点。

那么,怎么在这个充满不确定的世界里生存?

塔勒布给出了一个具体的方法:杠铃策略。

杠铃策略的意思是,把资源分配到两个极端:一头极端保守,一头极端激进,避开中间地带。

在投资上,就是90%的钱放在几乎零风险的地方,10%投在高风险高回报的机会上。

最坏的情况是损失10%,但收益没有上限。

而那些百分之百投资“中等风险”的人,会因为风险计算错误而完全毁灭。

中等风险最危险,因为它给你一种“稳定”的错觉,但其实既没有安全垫,也没有爆发力。

看完这本书,我开始用杠铃法则重新分配生活,整个人的状态变了。

以前我总想在工作和创业之间找平衡,结果两边都做不好。

工作不敢太投入怕没时间创业,创业不敢全力以赴怕没收入。

看起来在平衡,其实是在两头摇摆,焦虑得要死。

后来我明白了,塔勒布说的“杠铃”不是妥协,而是极端化。

一头极端保守:上班,拿工资,这是我的安全垫。

我不追求在公司里升职做到高管,也不幻想靠这份工作实现财务自由。

它的作用只有一个——让我活下来,给我时间。

一头极端激进:创业项目,all in,不设上限。

失败了最多损失的是时间和小额成本,但成功了收益是指数级的。

我不再追求那种“稳步上升”的幻觉。

因为在一个非线性的世界里,稳步上升本身就是个伪命题。

我上班的这几年,不是在浪费时间,而是在买一个保险。

它保证了即使我的创业项目全都失败,我也不会流落街头。

有了这个保底,我才敢在创业项目上真正冒险,去尝试那些回报很高但不确定性也很高的方向。

没有这个杠铃结构,我要么困在舒适区不敢动,要么破釜沉舟赌一把然后爆掉。

而现在,我在用时间换可选择性。

每一个失败的项目都在给我反馈,告诉我什么行不通。

每一次小规模的成功都在积累势能。

我不知道哪一个项目会真正起飞,但我知道——只要我一直在场、一直在试错,我遇到它的概率就在增加。

这才是杠铃策略的精髓——用确定性保护你的下限,用可选择性打开你的上限。

这才是真正的反脆弱——不是跑得最快,而是活得最久。

世界不会变得更稳定,只会更混乱。

与其追求一个不存在的稳定,不如让自己成为那个能在混乱中获益的人。

今后5-10年在日本投资的思考

又停更一段时间了,主要是因为懒,不想写。现在每天过着简单的日子,除了陪家人之外,就是想着投资。今天再写投资话题,立足日本,和大家分享。篇幅比较长,请耐心看。

一、应该如何投资

很多人买完股票或交易商品,跌了惶惶不可终日,涨了就神经兮兮不淡定。

投资的目的是改善生活,拓展生活的乐趣和意义。如果一个投资让自己心神不宁,血压升高,这种投资也就失去意义了,不做也罢。还有些人,喜欢把鸡蛋放在一个篮子里,不愿经历时间的积累,总想一夜暴富,把投资当押宝,过着有了今天没明天的日子。

投资本身必须令人安心。我们只是普通人,根本不可能抓住短期某股票或商品的涨跌。切不可听风,更不能偶尔蒙对一次就觉得自己是巴菲特。连国际专业机构的团队也经常做出错得离谱的预测。有大型金融机构研究来研究去,最终把自己研究破产了。而我们这些金融知识不健全、IQ非常普通的人,如何能确定自己比大部分人聪明,能玩得过市场?

分散、被动、顺势的投资,才是普通人的财富之路。

二、投资赚钱的背后逻辑

投资为什么一定可以赚钱?最主要的原因是社会在发展。

人类社会始终是在向前发展的。历史上,哪怕是毁灭性的战争之后,也能再迅速发展起来。发展是永恒的趋势,也是投资必能赚钱的最大逻辑和信心来源。

社会在发展,与每个人都息息相关,但是相关性有大有小,有远有近。社会发展了,有的人吃住改善了,涨工资后有点闲钱了,但是算起来,还是落后于时代发展的脚步。而有的人,登上时代发展的列车,吃尽了发展的红利。

什么是发展的红利?房地产发展上升期,你买房了,你就吃了房地产发展的红利。当前的Ai时代,你用适当的形式参与进去了,你就吃上了Ai时代的红利。

我们普通人做不了时代的弄潮儿,无法领航方向。我们能做、且必须要做的是,搭便车。别人吃肉,我们喝汤。你能喝上时代发展大杂烩中的一口汤,就超越了大部分人。

这个世界上的大部分人,虽然也在经历时代的发展,目睹世界的各种变化,但是他们似乎永远只是个旁观者,完全没有参与进去。别人吃肉,你喝汤,而这些人也就只能闻个味儿。这个味儿,就是他们在推特微博上吹牛逼、指点江山的本钱。

投资赚钱的另一个逻辑是世界的此消彼长。商品的此消彼长,国家的此消彼长,都给了我们逐利的机会和可能。这个世界,通常有一样东西暴涨,就一定有别的东西下跌。而这种此消彼长一般都有周期性。三十年河东,四十年河西,我们永远不缺逐利的机会。

一个社会的发展趋势通常是明确的,且不会在短期内有翻天覆地的改变。我们要做的是看清楚趋势,采取行动。

这个世界并不缺能看清楚趋势的人,缺的是能面对趋势积极采取行动的人。非常多的人在趋势面前如同傻子一样,什么也不做。

当然,追逐趋势也有赌的成分。在百家乐赌桌前看牌路趋势是傻,你把钱押上去,一切老天爷决定,你什么也做不了。

但是,这个世界的发展趋势确是实实在在的。看准了趋势路数去分散投资,这种赌往往是靠谱的,是必须的。

三、如何定义赚钱

赚钱还需要定义?我口袋里的钱多了,账户里的数字变大了,不就是赚钱了?

还真不是这样。比如,你5年前把人民币换成日元,在日本的非核心地段买了一栋小楼。5年后,你把它卖了,赚了30%。你赚钱了吗?表面上是,但是如果考虑到你当时是拿多少人民币买的,算起来你可能还亏了20%。折腾了5年,赔本赚吆喝。

有人说,我已经来了日本了,我就以日元计算,人民币与我无关了。错,财富不是以哪国的货币来计算的,是以其实际价值来计算的。

所以,投资赚钱一定要有“本金”(base currency)的概念。每项投资,永远用本金去衡量投资的盈亏。有了本金的概念,才会重视汇率走势在投资中的重要作用,才会去想办法对冲、趋利。

你在美元兑日元130的时候买了一只股票或商品,今天涨了15%你给卖了。如果用日元来算,你赚了。如果考虑日元贬值的因素,你亏了。

写这段,主要是想引出汇率话题。

四、今后5-10年的日元汇率走势

关于日元汇率,我写过不止一次。以前写的时候,话说得都有所保留,不愿说得太直白。

今天给写直白一点:美元兑日元5年内达到180是非常大概率的事情。抛弃所谓美国降息,日本加息,日元会回到110-130的幻想吧。完全不可能!

既然日元贬值的趋势不可避免,你坐在那里啥也不做,就是对自己不负责任了。因为这是个大概率事件,也可以把它当作一个机会。在机会面前,大胆投资。

我很少碰大A,不会玩。股票投资我主要买日本和美国股票。在做资金分配时,通常50/50。一半资金买日本股票,一半买美股。

最近日本股市高歌猛进,日经指数已经突破了5万大关。市场不断传出包括巴菲特在内的大佬和投资机构加仓日本股市,让人感觉日本股市就是一个提款机,希望满满。

在这个背景下,我做了一个逆向决定:把一直以来日美股市资金的一半一半,变成美股80%,日股20%。

这看起来似乎是在走极端,其实是非常理性的决定。我认为,当前还在加码日本股市的人才是在走极端。

无论是汇率,还是社会方方面面的发展速度,美国今后都会把日本碾压。

所以,减少日股,增加美股,是明智之举。

毕竟,赚钱是有定义的。

五、买啥呢?

很多在日本的朋友不太了解美国股市。一开始玩,要么是听风,要么是玩“七姐妹”。

玩七姐妹也是不错的选择,毕竟美国在今后可预见的将来,依然是全球科技发展的领头羊。而七姐妹涵盖了几乎全部热门赛道,包括人工智能、自动驾驶、云计算、网络安全、网络电商等热门投资领域。

但是七姐妹也有选哪个的问题。比如,我会用一部分资金来买微软、英伟达、特斯拉,别人会更看重谷歌、亚马逊。也有我理解不了的人紧抱着Meta(Facebook)不放。这些都是个人选择问题,也都是在片面押注。

普通人正确的投资方式应该有两步。1、找出你认为接下来几年美国必然会发展迅速,几乎没有悬念的领域;2、买这个领域最优的ETF。

做了这样的投资,你心里会很稳,内心会比别人平和很多。根本不在乎一时的涨跌。你甚至可以完全忘记它。5-10年中,每年给你带来平均9%-25%的复利收益。

那么,投资哪些领域是今后美国稳赚不赔的呢?每个人的观点不同。这里说说我的看法。

我的首选是网络安全。有人会说,网络安全很重要,但没必要放在首选吧?

网络安全是个永恒的话题,是永远的攻守之道,永无止境。你永远不会听说哪天人们停止或减少在网络安全方面的投入。魔越来越高,道越来越强,人们只能不断掏银子保平安。个人看法,未来几年在这个领域投资,几乎看不到亏钱的可能。

网络安全这个领域,有好几个ETF。CIBR和HACK都不错。我选择CIBR,因为我永远选择最好的。篇幅有限,这里无法展开细述。

其次是人工智能。我这里说的人工智能指的不仅是Ai,也包括人型机器人、工业机器人及制造过程自动化。人工智能真正赚钱的时代还没有到来。什么时候机器人在美国大地家家户户,各个工厂开始普及了,那才是真正人工智能的黄金时代。

中美这两天似乎相互达成了妥协,这是好事。但是,必须清醒地认识到,一切都只是暂时的。和是一时的妥协,干才是永恒的主题。

这次因为稀土等原因,老美的蛋被老共捏了一把,搞得前言不搭后语,汗都下来了,没办法。老美总算是被人治了一回。对于美国来说,没了稀土,不是断供的问题,是断代的问题。

这个问题,至少5年内,老美搞不定。而我党当前也面临各种困难,也需要一个喘息的时机,这是此次中美达成协议的大背景。

这与我们投资有什么关系?

老美尝到了放弃制造业的苦果,接下来必然会大力发展制造业。缺少人工,人工智能和自动化生产就是唯一的选择。

人工智能领域的ETF太多。我选的,是广义的人工智能。在BOTZ和ROBO之间,我选择BOTZ,不仅是因为ROBO每年的费用太高,因为我只选最好的。

另外,在医疗方面的人工智能发展也非常迅速,不应该错过。在这方面,我直接买了股票,没买ETF。比较之下,感觉这个领域的ETF,比如XLV,不如直接买龙头股。

第三个领域,我选基础建设。美国和日本都面临一个共同问题:基础设施老旧化。这两个国家在今后10年都必然会、也不得不加大基础建设的投入,从新建,到修修补补,都要花钱,很大很大的钱。

美国这个领域的ETF选择,PAVE当仁不让。因为它是最好的。

篇幅有限,就这样闭着眼写下去,我能把这篇写成一本书。哈哈。在此篇成书之前,还是收笔吧。

收笔之前,和大家分享一个词“DX”,即Digital Transformation。这个词距离首次被提出来已经20年了。十几年前,随着云计算、大数据的发展开始引得人们关注。最近几年,特别是在2018年被纳入日本政策发展框架后,在日本变得常见。比如Medical DX。

日本很多领域真的是刚刚开始DX。它无论在创业,还是投资方面,都提供了一些致富的机会。

Cool retweeted

最近写得比较多,主要还是围绕 AI时代的红利和芯片产业的投资机遇。

从半导体、公司、交易、心理到宏观,每一篇都是在讲故事,更是在拆结构。

我不求篇幅,只想每篇有逻辑、有不一样能打中要害,多一句都是浪费。写完自己也能回头验证预判。

所以干脆做个合集方便我自己复盘,也方便你一键直达⬇️

芯片行业分析:

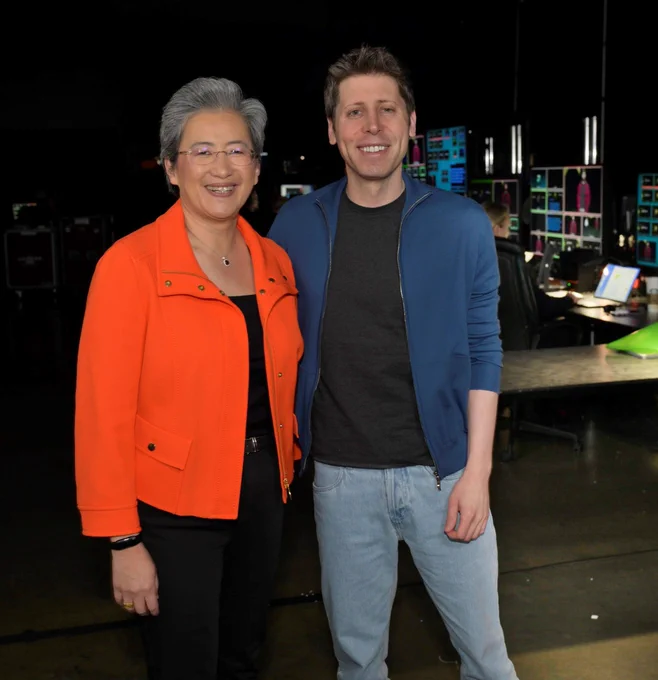

$AMD 和OpenAI芯片加股权对赌的交易分析

x.com/tig88411109/status/197…

$INTC 英特尔和$NVDA 英伟达交易分析

x.com/tig88411109/status/196…

利好HBM 高带宽存储芯片$MU

x.com/tig88411109/status/197…

$NVDA 和OpenAI 投资购买策略分析

x.com/tig88411109/status/197…

$INTC 英特尔美国投资和的产业回归价值系列

x.com/tig88411109/status/196…

x.com/tig88411109/status/197…

x.com/tig88411109/status/197…

交易端分析 :

AMD股价走势的分析 为何一切刚刚开始?

x.com/tig88411109/status/197…

长期投资也需要抓住AI时代红利

x.com/tig88411109/status/197…

为何Buy the Dip 最好策略

x.com/tig88411109/status/197…

需求端分析:

AI是时代机遇和GDP最大增量

x.com/tig88411109/status/197…

AI云计算数据中心的需求泡沫是否破灭?

x.com/tig88411109/status/197…

AI的需求渗透性

x.com/tig88411109/status/197…

ChatGPT的多样化发展

x.com/tig88411109/status/197…

电力端分析

电力即是电力

x.com/tig88411109/status/197…

交易心理分析

x.com/tig88411109/status/197…

创始人价值分析

x.com/tig88411109/status/197…

中国地缘政治分析

x.com/tig88411109/status/197…

底层逻辑

中推全网独家 宏观预测:

关键是市场钱太多的背后全网第一:关税不等于通胀的分析

x.com/tig88411109/status/188…

2025年开启AI效率投资时代

x.com/tig88411109/status/186…

投资标的 美股代码

x.com/tig88411109/status/186…

Cool retweeted

非常精彩的一篇分析新闻稿

科技新闻类报道,也被颠覆了

OpenAI的芯片博弈:百亿美元豪赌背后的战略与权力

OpenAI在2025年打出了AI基础设施史上最大的一手牌:同时与NVIDIA和AMD签署总价值超过1600亿美元的GPU采购协议。这不仅是商业合同,更是一场重塑AI芯片市场权力格局的深度博弈。

2025年9月22日,Sam Altman宣布与NVIDIA达成1000亿美元战略合作,部署至少10吉瓦(约400-500万颗GPU)的计算能力。仅两周后的10月6日,OpenAI又抛出震撼弹:与AMD签署6吉瓦部署协议,预计带来数百亿美元收入。AMD股价单日暴涨23%,而这一系列动作背后,是AI时代最激烈的供应商博弈与战略算计。

这场游戏的核心矛盾是:OpenAI每年需要600-800亿美元的GPU支出,但2025年营收仅100-200亿美元。在技术依赖、成本压力、供应安全的三重约束下,Altman必须在NVIDIA的技术霸权与AMD的性价比之间走钢丝,同时利用公开承诺制造谈判筹码。本报告将解析这场涉及数千亿美元、影响全球AI产业的权力博弈。

核心事件时间线:从独家到多元化的战略转向

OpenAI的GPU采购策略经历了从完全依赖到激进多元化的戏剧性转变。2024年5月是转折点:AMD的MI300X芯片开始通过微软Azure为OpenAI提供服务,首次打破NVIDIA的垄断地位。这一看似技术性的调整,实则预示着Altman布局已久的供应商制衡战略正式启动。

2025年1月21日,微软官方宣布OpenAI不再是其独家云服务客户,改为"优先购买权"安排。次日,OpenAI联合软银、甲骨文发布Stargate项目:4年5000亿美元投资计划,首期1000亿美元立即部署。这标志着OpenAI从依附微软Azure转向自主构建多云基础设施的战略独立。

真正的高潮出现在2025年9月。9月22日的NVIDIA协议规模空前:10吉瓦容量、逐吉瓦部署、首批交付定于2026年下半年。Jensen Huang亲口表示这是"史上最大AI基础设施项目",相当于NVIDIA一年的出货总量。但协议措辞微妙——NVIDIA被定义为"首选合作伙伴"而非"独家",且作为"被动投资者"参与,这为后续变化埋下伏笔。

仅两周后的10月6日,AMD协议落地,细节更加激进:不仅是6吉瓦采购(首个吉瓦同样定于2026年下半年),还包括AMD向OpenAI发放1.6亿股认股权证(约占AMD总股本10%),行权条件与AMD股价挂钩(最高目标600美元/股)。AMD被称为"核心战略计算合作伙伴",措辞强度甚至超过NVIDIA。AMD CFO Jean Hu明确表示这将带来"数百亿美元收入"。

这一系列协议的总价值惊人:NVIDIA 1000亿、AMD 600亿+、甲骨文3000亿(5年期)、CoreWeave 224亿(三份合同累计)。OpenAI在不到一年时间内锁定了总计超过5000亿美元的计算资源,年均支出600-800亿美元——这是其当前年营收的4-6倍。

更值得注意的时间同步性:NVIDIA和AMD的首个吉瓦部署都定于2026年下半年,暗示OpenAI在同步推进两套并行基础设施。UBS分析师此前指出,AMD"明显缺席"Stargate项目初期公告,因此判断项目将严重依赖NVIDIA。但10月的AMD协议证明,Altman早已在暗中布局双轨策略,只是等待最佳时机公开。

战略动机:供应链焦虑与成本压力的双重驱动

OpenAI激进多元化的第一驱动力是真实而严峻的GPU短缺危机。2025年3月,Altman在社交媒体坦承"我们的GPU正在融化",被迫对图像生成功能实施限流(免费用户每天仅3张)。2月,GPT-4.5发布因"GPU耗尽"推迟。他直言OpenAI被迫做出"不自然的事情"——从研究团队借用算力、暂缓新功能、对用户实施访问限制。

这不是谈判策略,而是运营现实。OpenAI拥有7亿周活用户,但计算能力无法匹配病毒式增长速度。Altman在7月宣布目标是"2025年底前上线超过100万颗GPU",随后又表示需要"再增长100倍"——即1亿颗GPU,相当于3万亿美元投资。这种数量级的需求下,任何单一供应商都无法满足,多元化成为生存必需而非战略选择。

成本因素更加赤裸。NVIDIA H100售价3-4万美元,H200达3.5-5万美元,而AMD MI300X仅1-1.5万美元——价差达2-4倍。在16,000颗GPU的集群规模下,选择AMD可节省约40%资本支出(NVIDIA集群5.5-8.4亿美元 vs AMD集群2.1-3.2亿美元)。对于年均需要投入数百亿美元、但2025年营收仅100-200亿的OpenAI,这种成本差异关乎生存。

NVIDIA的定价权源于其78%的惊人毛利率(AMD为47%,Intel为41%)。汇丰银行分析师直言"震惊于NVIDIA在AI芯片上的定价权"——AI芯片售价是游戏芯片的10-20倍,但成本增幅远小于此。在垄断地位下,NVIDIA有能力维持这种暴利,而OpenAI作为最大单一客户,却无力单独制衡。

更深层的担忧是循环融资风险。NVIDIA投资1000亿给OpenAI,OpenAI转手购买NVIDIA的GPU,资金回流至NVIDIA——这与2000年互联网泡沫时期的供应商融资模式惊人相似。伯恩斯坦分析师Stacy Rasgon警告:"这显然会加剧'循环融资'担忧……距离危机还有一段距离,但随着AI估值飙升,这段距离正在缩短。"NewStreet Research估算:NVIDIA每投资100亿美元给OpenAI,就能获得350亿美元GPU采购回报,占其年收入27%。

Altman面对的核心困境是:NVIDIA既是OpenAI最关键的合作伙伴,也是潜在的制衡目标。NVIDIA同时投资100多家AI公司,包括OpenAI的竞争对手;它也在发展自己的AI服务;它必须在微软、Meta、Google、xAI等客户间分配稀缺的GPU产能。在这种结构下,完全依赖单一供应商等同于将命运拱手相让。

Sam Altman的谈判杠杆:规模、替代性与公开施压

Altman手中握有三张王牌。

第一是无可替代的市场地位:7亿周活用户、5000亿美元估值、AI消费级应用的绝对霸主。OpenAI是全球最大的AI算力消费者,失去这一客户对任何芯片供应商都是重大打击。2025年OpenAI的计算采购规模预计占NVIDIA数据中心收入的15-20%,这种体量本身就是谈判筹码。

第二是可信的替代选项。OpenAI不仅宣布与AMD合作,还在使用Google Cloud的TPU运行ChatGPT和相关服务——这是首次大规模偏离NVIDIA生态。甲骨文3000亿美元云协议、CoreWeave多达224亿的三份合同、微软Azure的深度集成,都证明OpenAI有能力快速切换基础设施。更关键的是,这些替代方案不是威胁,而是已经在生产环境中运行的现实。

Altman将这种能力公开化以制造压力。他频繁在社交媒体发布关于GPU短缺的信息("GPU正在融化""我们已经没有GPU了"),营造稀缺叙事;他公开表示需要1亿颗GPU(当前的100倍),迫使供应商竞争战略地位;他将NVIDIA描述为"被动投资者"而非主导伙伴,弱化依赖性。

第三是结构性谈判策略。OpenAI采用"首选"而非"独家"关系定位,在协议中保留灵活性;它从直接购买转向租赁模式,降低前期资本需求并维持供应商切换选项(虽然NVIDIA承担折旧风险);它将10吉瓦NVIDIA容量分散到多个合作伙伴(微软、甲骨文、软银、Stargate),避免单一故障点。

这种多线布局的高明之处在于:每一个公开承诺都是对其他供应商的暗示压力。当OpenAI宣布与AMD签署6吉瓦协议时,实际上在告诉NVIDIA:"我们有能力大规模迁移工作负载。"当它维持与NVIDIA的1000亿合作时,又在向AMD展示:"你必须证明软件生态成熟度,否则我们随时回到NVIDIA。"

Altman本人的表态微妙平衡。在宣布NVIDIA协议时,他说:"没有哪个伙伴能像NVIDIA一样以这种规模和速度完成交付"——这是认可。但在AMD协议后接受《华尔街日报》采访时,他又表示:"很难夸大获得GPU有多困难……我们希望速度超快,但这需要时间"——暗示NVIDIA供应不足。这种两面话术精准维持着微妙平衡。

NVIDIA的垄断护城河:技术霸权还能维持多久?

NVIDIA在AI芯片市场的统治地位近乎绝对:70-95%市场份额(多数估算为80-85%),78%的恐怖毛利率,4.5万亿美元市值峰值(一度成为全球最有价值公司)。

这种垄断源于三重护城河。

CUDA软件生态是最深的护城河。自2007年推出以来,CUDA已成为AI开发的行业标准,拥有18年的优化积累和广泛社区支持。几乎所有AI框架(PyTorch、TensorFlow、JAX)都以CUDA为默认目标,多数机器学习工程师只接受过CUDA训练。SemiAnalysis的5个月独立测试显示:NVIDIA H100"开箱即用",单条命令即可启动;而AMD MI300X需要60多条命令的Dockerfile从源码编译,构建时间超过5小时,还需设置数十个AMD特定环境变量。

硬件性能优势依然明显。在实际LLM训练任务中,H100的BF16训练性能达720 TFLOPS(理论值的73%),而MI300X仅620 TFLOPS(理论值的47%),慢14%。FP8训练中,H100达1,280 TFLOPS(65%利用率),MI300X仅990 TFLOPS(38%利用率),慢22%。在Mistral 7B等采用滑动窗口注意力的模型上,H100比MI300X快2.5倍。多节点训练场景中,随着集群规模增加,NVIDIA的NVLink交换拓扑相对AMD的xGMI点对点拓扑优势进一步扩大,性能领先10-25%。

供应链控制和客户关系网同样关键。NVIDIA通过2019年收购Mellanox获得领先的GPU互联技术;它与台积电深度绑定,优先获得最先进制程产能;它对SK海力士、美光的HBM3E高带宽内存有优先分配权;它与所有主要云服务商(AWS、Azure、GCP、Oracle)建立了深度技术集成。这些关系不是一朝一夕能够复制的。

然而,裂痕正在出现。2025年1月的DeepSeek冲击是转折点:中国初创公司DeepSeek声称用600万美元和出口限制版的H800芯片(性能远低于H100),训练出与GPT-4竞争力相当的模型。消息传出当日,NVIDIA市值单日蒸发6000亿美元——美国公司史上最大单日损失。虽然NVIDIA股价随后反弹,但DeepSeek证明了一个危险事实:通过算法优化和效率突破,可以大幅降低对顶级硬件的依赖。

监管压力同步升温。美国司法部正调查NVIDIA涉嫌反垄断行为,包括捆绑销售GPU与服务、独家安排、对优先购买竞品客户的惩罚性措施。中国也在反垄断调查中审查NVIDIA收购Mellanox的交易。欧盟对其市场支配地位保持关注。这些监管行动可能削弱NVIDIA的定价权和合同控制力。

更结构性的威胁来自超大规模客户的自研芯片。Google的TPU v6(Trillium)已为Gemini等模型提供支持;亚马逊的Trainium/Inferentia专注训练和推理;微软的Maia 100和Cobalt 100虽然进展缓慢但目标明确;Meta的MTIA已在内部工作负载中使用。摩根大通估计,到2028年云服务商的定制芯片市场将达300亿美元,年增长20%。这些巨头合计占据NVIDIA数据中心收入的40%以上,它们的自主化努力将逐步侵蚀NVIDIA的份额。

AMD的历史性机遇:技术追赶与软件短板

AMD的MI300X在硬件规格上拥有显著优势:192GB HBM3内存(H100仅80GB,多2.4倍)、5.3 TB/s带宽(H100为3.35 TB/s,高60%)、256MB三级缓存(Infinity Cache)。在特定工作负载下,这些优势转化为实际性能:Llama2-70B推理任务中,MI300X比H100延迟降低40%,主要得益于更高的内存带宽;在小批量(1-4)和大批量(256-1024)推理场景下,MI300X成本效益优于H100。

价格优势更加突出。MI300X售价1-1.5万美元,仅为H100(3-4万美元)的25-37%。在16,000颗GPU集群规模下,选择AMD可节省约3.5-5.2亿美元资本支出(40%成本削减)。网络成本方面,AMD生态支持以太网而非昂贵的InfiniBand,进一步节省40%网络开支(收发器和白盒交换机更便宜)。对于需要部署数万甚至数十万颗GPU的OpenAI,这种成本差异具有决定性意义。

OpenAI的背书对AMD具有标志性验证效应。在此之前,AMD主要服务推理工作负载(Meta使用MI300X进行推理,但不用于训练),缺乏在前沿大模型训练上的成功案例。OpenAI的6吉瓦承诺,尤其是明确将用于训练和推理的表述,证明AMD已被AI最前沿公司认可为"核心战略合作伙伴"。这一信号将加速其他客户采纳AMD方案。

AMD的股权激励结构同样精明。1.6亿股认股权证(约10%股本)分批行权,与部署里程碑和AMD股价挂钩(目标价最高600美元/股,当前约165美元)。这意味着:(1)OpenAI与AMD利益深度绑定,有动力推动AMD成功;(2)AMD通过股权而非现金补偿了部分价格折扣;(3)双方形成长期战略联盟而非单纯买卖关系。这种结构比NVIDIA的"被动投资者"定位更紧密。

然而,AMD面临软件生态的致命短板。SemiAnalysis历时5个月的深度测试得出严厉结论:"MI300X无法开箱即用"——公开发布版本BUG频发,Flash Attention内核在数月内以<20 TFLOPS运行(BUG未被发现),FP8训练会导致段错误,FlexAttention功能(NVIDIA在2024年8月发布)到2024年12月在AMD上仍无法工作。

ROCm软件栈质量问题严重。它需要PYTORCH_TUNABLE_OPS标志进行性能调优(每个模型1-2小时),任何代码更改需要重新调优,存在25GB内存泄漏,启发式模型默认选择错误算法。RCCL(NVIDIA NCCL的AMD分支)在集合通信上慢2-4倍(all_gather、reduce_scatter、all_to_all),128颗以上GPU规模的all_reduce操作慢50%。这些性能损失在大规模训练中被指数级放大。

更糟糕的是,AMD在实际生产环境测试严重不足。据报道,AMD的RCCL团队研发用的MI300X不到32颗,而NVIDIA拥有11,000多颗H100集群用于内部测试。这种研发资源差距导致AMD的CI/CD流程薄弱,BUG频繁进入生产版本。Meta虽然部署MI300X,但仅用于推理且使用定制内核,完全回避训练工作负载——这本身就说明问题。

OpenAI与AMD的合作能否改变这一局面?关键在于OpenAI是否会投入工程师团队深度优化ROCm。如果只是期待AMD提供"即插即用"解决方案,那么这6吉瓦部署将面临严重执行风险。但如果OpenAI像Meta那样组建专门团队开发定制内核(OpenAI的Triton编译器已支持MI300X),并与AMD工程师深度协作,那么ROCm生态有望在OpenAI的实战需求推动下快速成熟。AMD CFO明确表示这是"变革性的,不仅对AMD,对整个产业动态都是",暗示AMD将投入巨大资源支持这一合作。

产业格局重塑:从垄断到寡头竞争

OpenAI的双轨战略标志着AI芯片市场从NVIDIA近乎垄断向寡头竞争过渡。最直接的影响体现在股市反应:AMD协议宣布当日,AMD股价盘前暴涨23%,市值增加约650亿美元;NVIDIA虽然小幅下跌1%,但随后稳定,显示市场认为多元化并未根本威胁其地位。

NVIDIA的市场份额将缓慢侵蚀,但远未崩溃。主流分析师预计,未来3-5年NVIDIA份额将从当前的80-85%降至60-70%,但仍保持领先。关键原因是:(1)CUDA生态的转换成本极高,现有客户短期内难以大规模迁移;(2)性能领先仍然明显,尤其在训练工作负载上;(3)Blackwell架构(B200/GB200)承诺相对H100实现4倍训练速度、30倍推理速度,技术代际优势依然存在;(4)供应链掌控力短期难以撼动。

但定价权将受到实质性挑战。78%的毛利率在竞争环境下不可持续。当OpenAI等大客户拥有2-4倍价差的可信替代方案时,NVIDIA必须在保持技术溢价与维护客户关系间平衡。分析师预计NVIDIA毛利率可能在3-5年内压缩至60-65%——仍然非常健康,但显著低于当前水平。年化GPU价格降幅可能达到10-15%,而不是历史上的5-10%。

AMD有望在2027年前达到10-15%市场份额,前提是软件生态快速改善。OpenAI的6吉瓦承诺本身就可能占AMD 2025-2027年AI GPU出货量的25-30%。如果执行顺利,甲骨文(已订购30,000颗MI355X)、微软Azure(MI300X VM已上线)、Meta(推理部署)等客户的采纳将加速。AMD在2024年AI芯片收入目标为40亿美元,OpenAI合作"未来数年将贡献数百亿美元",意味着到2027-2028年,AMD AI收入可能达到150-200亿美元年化规模。

超大规模云服务商的定制芯片将占据15-25%份额。Google TPU已在内部大规模使用,为Gemini、Imagen等提供支持;亚马逊的Trainium 2号称训练性价比优于GPU;微软虽然进展缓慢但长期意图明确。这些定制方案不会进入公开市场,而是降低巨头自身对NVIDIA的依赖。摩根大通估计,到2028年这一市场将达300亿美元规模。

创业公司和中国玩家面临更艰难竞争。Cerebras的巨型晶圆级芯片、Groq的LPU架构、Tenstorrent等虽然技术新颖,但在OpenAI这种超大规模客户选择NVIDIA+AMD双轨后,留给小玩家的市场空间被压缩。中国的华为Ascend系列虽然在国内有政策支持,但2024年产量仅20万颗(NVIDIA在中国销售了100万颗H20),良率仅20-40%,与领先厂商差距仍大。

更深层的影响是"循环经济"模式受到质疑。NVIDIA投资OpenAI 1000亿,OpenAI购买NVIDIA GPU,资金回流;NVIDIA持有CoreWeave约7%股权(30亿美元),CoreWeave已向NVIDIA采购75亿美元H100。美国银行分析师Vivek Arya估算,NVIDIA对OpenAI的交易可能产生高达5000亿美元收入。分析师们开始公开比较这种模式与2000年互联网泡沫时期的供应商融资——当时思科等公司向客户提供贷款购买设备,泡沫破裂时损失惨重。

问题在于:AI需求有多少是真实的,有多少是NVIDIA融资催生的?如果链条中任何一环断裂(OpenAI未能实现盈利、云服务商AI收入不达预期、效率突破降低GPU需求),整个生态可能面临剧烈调整。DeepSeek事件已经展示了这种风险:一个600万美元预算的项目挑战了"必须大力出奇迹"的假设,NVIDIA单日蒸发6000亿美元市值就是市场对此的恐慌反应。

深层博弈:Altman的多线平衡与产业权力重构

Sam Altman正在操盘一场极端复杂的多方博弈。他的真正目标不是选边站,而是建立制衡系统。通过同时承诺NVIDIA 10吉瓦和AMD 6吉瓦,他确保:

(1)任何单一供应商都无法卡住OpenAI的脖子;

(2)供应商间存在实质竞争压力;

(3)OpenAI在价格、优先级、技术路线上拥有谈判空间。

供应商多元化的必要性已从战略选项变为生存必需。在当前AI芯片供需失衡(需求超供给10倍)环境下,OpenAI即使签署了1000亿合同,仍可能因为NVIDIA优先供应微软Azure或Meta而面临短缺。通过AMD作为"核心战略合作伙伴",OpenAI获得了第二供应渠道。更关键的是,AMD的1.6亿股权证让OpenAI成为AMD重要股东(10%),这种利益绑定确保AMD在产能紧张时会优先保障OpenAI。

成本套利空间巨大。假设OpenAI计划部署100万颗GPU(Altman的2025年底目标),如果全部采购NVIDIA H100(3.5万美元均价),成本为350亿美元;如果30%切换至AMD MI300X(1.2万美元均价),可节省约70亿美元——相当于其2025年全年营收的35-70%。在不影响核心训练工作负载的前提下,将推理任务分流至AMD,是显而易见的经济理性。

但Altman面对的约束同样严峻。技术锁定效应难以短期突破:OpenAI的数千名工程师、数百个模型、数百万行代码都基于CUDA生态开发。即使AMD硬件性价比突出,迁移工作负载需要数百人年的工程投入——重写内核、调试性能、验证结果一致性、培训团队。这种转换成本远超硬件价差,解释了为何NVIDIA仍获得10吉瓦(高于AMD的6吉瓦)承诺。

时间维度是另一考量。NVIDIA和AMD的首个吉瓦都定于2026年下半年交付,但Blackwell架构(B200/GB200)已因设计缺陷和CoWoS-L封装产能限制推迟数月,卖空至少12个月。AMD的MI450系列虽然承诺2026年下半年,但AMD历史上产品延期也不罕见(MI300X本身就比原计划晚了几个月)。OpenAI通过双供应商策略对冲这一风险:如果NVIDIA延期,加大AMD采购;如果AMD延期,增加NVIDIA订单。

更隐秘的博弈发生在软件生态层。OpenAI开发的Triton编译器已支持AMD MI300X,这是一个信号:OpenAI可能正投入资源建设跨平台抽象层,降低对CUDA的依赖。如果成功,这将从根本上改变与NVIDIA的权力关系。但这是多年工程,短期内CUDA护城河仍难以逾越。Jensen Huang公开表示CUDA代表"20年的研发投入",并非虚言。

地缘政治因素增加了复杂性。美国对中国的芯片出口管制意味着NVIDIA必须为中国市场开发阉割版(H20),台海紧张局势威胁台积电供应链稳定,NVIDIA在中国面临反垄断调查。这些不确定性促使OpenAI分散风险——AMD同样依赖台积电,但产能需求更小,受地缘冲击的影响可能较低。

Altman在公开表态中的微妙平衡值得细品。宣布NVIDIA协议时,他强调"没有哪个伙伴能像NVIDIA一样",这是必要的尊重;但在AMD协议后,他又说AMD将"加速进步并更快将先进AI的好处带给所有人",暗示AMD是"加速器"而非"备胎"。这种话术精准维持着微妙平衡,既不激怒NVIDIA,也给AMD足够重视。

技术现实的冷酷真相:性能差距与软件生态

抛开商业策略,技术层面的现实冷酷而清晰:NVIDIA在生产环境性能上仍有显著领先,AMD的硬件优势被软件短板抵消。SemiAnalysis的5个月独立测试是迄今最详尽的第三方评估,结论几乎全面否定了AMD在训练工作负载上的竞争力。

训练性能:AMD落后14-22%。BF16精度下,H100实际性能720 TFLOPS(理论989.5 TFLOPS的73%),MI300X仅620 TFLOPS(理论1,307 TFLOPS的47%)。这意味着AMD的硬件利用率不到50%,白白浪费了纸面算力优势。FP8精度情况更糟:H100达1,280 TFLOPS(65%利用率),MI300X仅990 TFLOPS(38%利用率)。在实际模型训练中(GPT 1.5B、Llama 8B/70B、Mistral 7B),H100全面领先,部分场景快2.5倍。

多节点训练差距扩大。在单机8卡训练中,AMD尚能勉强跟上;但扩展到128卡及以上集群时,NVIDIA的NVLink交换拓扑(每GPU 450 GB/s,全连接)相比AMD的xGMI点对点拓扑(GPU对间仅64 GB/s)优势显著。集合通信操作(all_reduce、all_gather)是大规模训练的瓶颈,RCCL在这些操作上比NCCL慢50-400%。这意味着训练千亿参数模型时,AMD的劣势会被指数级放大。

推理性能:AMD在特定场景有优势,但H200大幅缩小差距。MI300X的192GB大内存和5.3 TB/s带宽在Llama2-70B推理中确实展现出40%延迟优势——但这仅限于H100比较。H200配备141GB内存和4.8 TB/s带宽后,性能比H100快45%(Llama 2 70B:31,712 tokens/sec vs 21,806 tokens/sec),基本抹平了MI300X的领先。更重要的是,推理性能高度依赖批量大小:MI300X仅在极小(1-4)和极大(256+)批量下有优势,中间批量(8-128)仍是H100更快。

软件生态的现实更为残酷。MI300X"无法开箱即用"意味着它根本不是通用产品,而是需要深度定制工程的半成品。OpenAI如果真要大规模部署6吉瓦AMD GPU(约25万颗MI450),必须:(1)组建专门的平台工程团队(数十到上百名工程师);(2)为每个模型和工作负载开发定制内核;(3)持续跟踪和修复ROCm BUG;(4)维护自己的编译器和运行时栈。这不是简单的"采购"决策,而是长期战略投资。

Meta的案例提供了参考。Meta部署MI300X仅用于推理,并开发了定制内核,完全避开训练。即便如此,Meta工程团队规模庞大(数千名AI基础设施工程师)。OpenAI虽然也有顶尖工程师,但优先级是构建和训练模型,而非底层系统优化。将资源分散到两个硬件平台(NVIDIA + AMD)可能降低整体效率——除非AMD生态快速成熟到接近CUDA水平。

即将到来的Blackwell架构(B200/GB200)可能进一步拉开差距。NVIDIA承诺相对H100实现4倍训练速度、30倍推理速度(FP4精度)。虽然实际性能打折扣,但如果能达到承诺的50-70%,B200仍将大幅领先AMD当前产品线。AMD的MI450要到2026年下半年才交付,届时面对的将是已经量产数月的B200,技术代际可能再次落后。

能耗和成本的真实对比也值得审视。H100功耗700W,MI300X为750W(高7%),单卡功耗相近。但H200保持700W功耗同时性能提升45%,能效比显著优于MI300X。未来的GB200功耗达1,200W,但如果性能提升2-3倍,能效比仍可能更优。从总拥有成本看,虽然AMD硬件便宜40%,但如果性能和软件成熟度导致需要更多GPU才能完成相同工作,成本优势将被侵蚀。

这些技术现实解释了为何OpenAI给NVIDIA的承诺(10吉瓦)仍高于AMD(6吉瓦)。核心训练工作负载——决定OpenAI竞争力的GPT-5、GPT-6等下一代模型——大概率仍将主要运行在NVIDIA硬件上。AMD的6吉瓦更可能用于:(1)推理服务(尤其是大批量场景);(2)较小模型训练(7B-70B规模);(3)实验性工作负载;(4)作为NVIDIA的备份和议价工具。

未来图景:从万亿投资到格局重塑

OpenAI的激进策略揭示了AI基础设施竞赛的真实规模:数万亿美元级别的长期投资。Altman声称100亿只是"小小的凹痕",需要"再增长三个数量级"——即从百万颗GPU到十亿颗,从千亿投资到百万亿。这种规模下,地球上没有任何单一供应商能够垄断市场。

未来3-5年的市场格局最可能演化为:NVIDIA保持50-60%份额,但毛利率从78%压缩至60%左右;AMD达到15-20%份额,成为可信的第二选择;超大规模云服务商的定制芯片占据20-25%,主要服务各自内部需求。总市场规模以25-30%年复合增长率扩张,从2024年的1230亿美元增至2029年的3100亿美元以上——足够大到支撑多个赢家,但竞争将空前激烈。

三种潜在情景值得关注。

情景一(概率60%):NVIDIA主导但非垄断。技术领先和CUDA护城河继续发挥作用,但份额缓慢侵蚀。AMD站稳脚跟,软件生态逐步改善。定价权分散,客户议价能力增强。行业进入相对健康的寡头竞争。

情景二(概率30%):快速碎片化。效率突破(如DeepSeek类事件)加速商品化进程。算法改进降低对顶级硬件的依赖。NVIDIA份额跌至40-50%,AMD达到25-30%,定制芯片扩展至25-30%。价格战爆发,全行业毛利率压缩,周期性波动加剧。

情景三(概率10%):范式转移。光子计算、类神经形态芯片或量子启发架构出现突破,现有玩家优势被侵蚀。时间窗口可能在2027-2030年。这种颠覆性变化难以预测,但AI芯片架构的根本性创新不能排除。

对OpenAI的影响同样深远。双轨战略提供了供应链韧性和成本优化,但执行复杂性显著增加:两套硬件平台、两套软件栈、更高的工程开销。如果AMD生态成熟速度不及预期,OpenAI可能被迫在性能(坚守NVIDIA)和成本(迁移AMD)间做痛苦权衡。

财务可持续性是终极考验。OpenAI承诺的总计算支出(NVIDIA 1000亿、AMD 600亿+、甲骨文3000亿、CoreWeave 220亿)意味着未来5年年均支出800-1000亿美元,但2025年营收仅100-200亿。这种倒挂只能依靠持续融资维持。穆迪已对甲骨文/OpenAI协议的财务可行性表示担忧,质疑OpenAI是否能产生足够现金流偿付这些承诺。如果OpenAI未能实现盈利预期,整个计算采购计划可能需要缩减,届时与AMD的6吉瓦承诺将首当其冲受到重新评估。

地缘政治和监管维度不容忽视。美中科技竞争将继续塑造供应链格局。美国对先进芯片的出口管制迫使中国发展本土替代(华为Ascend等),全球市场可能分裂为两个生态。NVIDIA面临的反垄断调查如果实质推进,可能削弱其合同控制力,客观上有利于AMD等竞争者。欧盟的《人工智能法案》和数字市场法规也可能影响AI基础设施市场结构。

结论:权力的微妙平衡与不确定的未来

Sam Altman与NVIDIA、AMD的千亿博弈,本质上是AI时代权力分配的缩影。OpenAI的双轨战略揭示了一个残酷现实:在当前技术和市场条件下,没有完美选择,只有权衡取舍。

NVIDIA提供最佳性能和成熟生态,但价格高昂、供应受限、存在依赖风险;AMD提供成本优势和供应多元化,但软件不成熟、性能打折扣、需要巨大工程投入。OpenAI的解决方案不是二选一,而是两个都要——用NVIDIA保证核心竞争力,用AMD控制成本并制衡NVIDIA,同时推动行业向更健康的竞争格局演化。

这场博弈的赢家不会只有一个。NVIDIA将继续统治市场,但其垄断地位和超额利润将受到挑战。AMD迎来历史性机遇,但能否把握取决于软件生态改善速度和大规模交付执行力。OpenAI获得战略灵活性,但财务压力和多平台复杂性是长期考验。

从更宏观视角看,这场博弈推动了整个AI基础设施生态走向成熟:打破垄断、促进竞争、加速创新、降低成本。这对整个AI产业是福音——当计算资源更易获取、价格更合理、供应更稳定时,AI应用的民主化才能真正实现。

但不确定性依然巨大。DeepSeek证明了效率突破可能瞬间改写游戏规则;地缘政治可能打乱供应链;技术范式可能突然转移;金融市场对AI泡沫的担忧可能自我实现。

在这个充满变数的棋局中,唯一确定的是:Sam Altman已经成功确保,无论风向如何变化,OpenAI都不会被单一供应商扼住咽喉。

这或许就是这场千亿豪赌的真正价值所在。

Cool retweeted

Sam Altman 的 神之一手

让我惊叹,是我之前低估他了

不愧是AI时代顶级玩家

合纵连横 玩的溜啊

事件概览

2025年9月22日:Sam Altman 宣布 OpenAI 与 NVIDIA 达成 1000 亿美元战略合作,计划部署 10 吉瓦(约 400–500 万颗 GPU)级别的算力。

2025年10月6日:OpenAI与 AMD 签署 6 吉瓦部署协议,预计带来 数百亿美元收入。AMD 股价当日暴涨 23%。

这两项协议合计涉及上万亿人民币的长期算力布局,是当前全球 AI 基础设施格局中最重磅的事件之一。

背景与动因

1. 算力瓶颈与成本危机

· OpenAI 每年 GPU 支出预计达 600–800 亿美元。

· 2025 年公司营收约 100–200 亿美元,远低于硬件投入需求。

· 成本与营收严重失衡,逼迫 Altman 必须重构供应链战略。

2. 技术依赖与供应安全

· NVIDIA 目前是唯一能支撑 GPT-5 级模型训练效率的成熟生态。

· 但其价格高昂、供货紧张,形成“算力霸权”。

· AMD 则提供更具性价比、但生态不完善的替代方案。

· 双方竞合,成为 OpenAI 能否打破垄断的关键。

战略逻辑:Altman 的“三重博弈”

① 技术层面:平衡性能与成本

· NVIDIA:技术领先 + CUDA 生态壁垒。

· AMD:开放架构 + 成本优势。

· Altman 选择“两条腿走路”,确保模型训练不中断,

同时用 AMD 牵制 NVIDIA 的议价权。

② 资本层面:公开承诺即谈判筹码

· 大规模宣布合作,是“市场化谈判”的策略。

· 通过舆论与资本市场制造压力,迫使供应商提供更优惠条款。

· 典型的“以市场换价格”的逆向博弈。

③ 产业层面:算力主权的争夺

· OpenAI 希望控制自己的算力池,而非依赖微软云或 NVIDIA 云。

· 10 + 6 吉瓦部署,是在为“AI 超级主权”打地基。

· 最终目标:形成自有计算资产,与微软/NVIDIA 平起平坐。

结果与影响

对 OpenAI 而言:

· 实现供应链多元化,降低单一依赖风险。

· 借助 AMD 合作,强化自身在算力生态中的议价力。

· 同时向资本市场传递“增长确定性”信号。

对 NVIDIA 而言:

· 短期稳住最大客户,但长期被迫降价、开放。

· 垄断地位首次受到实质性撼动。

对 AMD 而言:

· 获得史上最大 AI 客户背书,跻身第一梯队。

· 资本市场信心爆发,开启高速扩张周期。

本质洞察

· 算力即货币:AI 时代的“石油战争”已经开打。

· Altman 的真实目标不是省钱,而是建立独立算力主权。

· 公开合作 ≠ 真合作:更多是一种战略信号,意在价格、控制权与未来生态标准。

Today, we’re announcing a multi-year, multi generation strategic partnership with @OpenAI that puts AMD compute at the center of the global AI infrastructure buildout.

✅ 6GW of AI infrastructure

✅ Initial 1GW deployment of AMD Instinct MI450 series GPU capacity beginning 2H 2026

✅ Enabling very large-scale AI deployments and advancing the entire AI ecosystem

More here: bit.ly/3KzsnFk

Cool retweeted

👉Charlie Kirk:“在西方能有文明社会,唯一的原因是:在西方你想要两条面包,你得靠挣来的,你不能从别人那里抢过来。”

一位学生说:“资本主义吸食工人阶级的血。”

Charlie没有嘲讽,只是非常耐心温柔追问:

如果反对市场,为何享用它的便利?

马克思主义成功过吗?

自动化能抹平差异吗?

自由市场把个人能力的差异,编织成分工协作的网络

Cool retweeted

完整版:

川普在今天与普京的历史性阿拉斯加峰会后,FOX电视台独家专访👇

两分钟就能看透一个人。

川普和普京见面,他摸到了什么底?

普京亲口承认,如果换个人,这场仗根本不会打。

这场历史性的会晤,到底谈了什么?

来看一下。

川普说,他和普京关系一直不错,本来可以一起干大事。

俄罗斯有什么?

国土世界第一,横跨11个时区,稀土、石油、天然气,资源多到无法想象。

但“通俄门”这个骗局,搅黄了一切。

会谈的核心:乌克兰。

川普的目标很直接:别再死人了。

战争每周要死掉七千人,大部分是俄罗斯和乌克兰的士兵。

普京给了个重磅信息:

如果川普是总统,战争根本不会发生。

为什么?

川普的答案是:拜登政府的无能。

这件事,已经让数百万人丧生,是二战以来最惨烈的事。

谈判进展到哪了?

川普说,很多关键问题已经谈妥了。

比如土地交换,比如提供北约之外的安全保障。

他说,“我们距离达成协议已经很接近了”。

但,协议没敲定,就不算数。

现在,球踢到了泽连斯基脚下,他必须点头。

欧洲国家也得参与进来,不能只当旁观者。

那普京为什么愿意坐上谈判桌?

牌是怎么打的?

第一张牌,欧盟。签订贸易协议,近一万亿美元的美国石油采购承诺,直接抢了本该流向普京战争机器的钱。

第二张牌,印度。想进口俄罗斯石油?加征50%关税。

第三张牌,北约。过去出钱不积极的国家,现在付款比例从2%涨到了5%。

一个聪明人,尊重的是实力。

川普说,拜登在任时,美国没有得到尊重。

但这中间有个战略失误。

拜登政府硬是把中共国和俄罗斯推到了一起。

这在历史上是大忌。

一个有广袤的土地,一个有庞大的人口,这本是天然的矛盾体。

愚蠢的操作,让他们走到了一块。

会谈还聊到一个有意思的话题:2020年大选。

普京的观点是:选举被操控了,因为邮寄选票。

他说,全世界没有哪个国家搞邮寄投票,因为这不可能有公平的选举。

最后,什么是“川普主义”?

不是孤立主义,而是“拒绝无休止的战争”。

第一任期,他用最快速度消灭了ISIS哈里发国;

解决了苏莱曼尼;摧毁了伊朗的核计划。

这些都是雷霆手段,不是拖泥带水。

他有能力结束战争,让大家坐下来谈。

怎么谈?用美国的经济实力。

比如,他用贸易协议调停了持续31年、死亡八百万人的刚果卢旺达冲突。

逻辑很简单:不和平,就不跟你做生意。

这次也是一样,他会亲自参加下一场普京和泽连斯基的会谈。

因为他首要的目标只有一个:救人。

Cool retweeted

用蛋白质拆解蛋白质(一)

人类消化的微观世界漫谈

我们吃进嘴里的蛋白质,其实就是别的生物的组成部分。牛排是牛的肌肉蛋白,鸡蛋清就是卵清蛋白,面包是小麦的谷蛋白,豆腐是黄豆的球蛋白,甚至一口菌菇,也是别的生命体辛辛苦苦搭出来的三维蛋白分子结构。

我们人类身体也是有成千上万种不同的蛋白质组成:血液中红血球里的血红蛋白,肌肉里的肌球蛋白,指甲里的角蛋白,皮肤下的胶原蛋白,血液里的免疫球蛋白。

不论是人的食物还是人类本身,所包含的这些叫做蛋白质的物质,在微观上都是一条长长的,有上百个或者更多氨基酸手牵手组成的链条。最底层的氨基酸只有二十几种。只不过,每种生物都有自己的图纸,按照不用顺序链接氨基酸,制造出不同的蛋白,再构成地球上千变万化的生物。

细究到底,每个动物都可以自己从头制造各种氨基酸,然后再用氨基酸合成蛋白质。但是,地球上的大部分动物,都不愿意自己干这个活(太消耗能量,太影响效率),不约而同地采用了直接拿别的生物的蛋白质来用,把蛋白质拆解成氨基酸。

所以,食草动物和食肉动物的本质都是把别人当“食材”,用“消化”这个动作拆解别人的蛋白质,形成了一个叫做“食物链”的大词。这个过程听起来残忍,其实本质上是一种分子级的重建。我们把外来的“建筑”拆成建材,重新搭建属于我们自己的房屋。

人类专门做这件事情的所有器官构成“消化系统”。包括,口腔,食道,胃、肠、这个通道,还包括:肝、胆、胰这些向通道注入消化液的腺体。

有趣的是,人类自己的消化道是由蛋白质搭建而成的,用来消化外来的蛋白质的消化液也是我们自身的蛋白质:胃蛋白酶、胰蛋白酶、糜蛋白酶。那么,为什么蛋白酶不先消化自己的胃和肠道,而是定向去消化食物。更神奇的是,既然大家都是蛋白质,为什么我们的胃不被蛋白质食物给反向消化了呢?

当年我问这个问题,被一句话给挡回来了:”你见过铁锤敲铁钉,也见过机床加工零件,为什么它们不能反过来?”今天看,这个回答并没有说到本质,但当时被唬住了。

这种“同类蛋白质定向分解而不误伤自己”的生化奇迹,是靠精密的结构识别、环境调控和延迟激活机制完成的。换句话说,我们体内住着一群“同类拆解专家”,拿着一把把精准的分子手术刀,专门拆解与他们成分相似、结构不同的外来同胞。

如果这套拆解机制失灵,外来蛋白保持原来的架构完整性,那可就不是供你消化的“营养”了,而是入侵者。这些蛋白质独特的外形会引发免疫系统报警,于是我们就看到了麸质过敏,深海鱼虾过敏,坚果过敏这些严重的后果。

另外,几千年来人类使用火来煮熟食物,也是另一个不可忽视的帮助。大部分人类食物,早在进入嘴巴之前,就已经经历了火的洗礼,我们已经不吃“活的蛋白”了。

加热的过程会让蛋白质“变性”,它原本复杂精密的三维结构在高温下塌陷、展开、凝固、失活,再也不是原来的“功能蛋白”,而是一坨无所作为的“氨基酸串”。所以,为什么从牛奶、鸡蛋、豆制品里来的蛋白,都能乖乖被吸收、同化,不引发大规模免疫抗议?

在牙齿进一步切碎之前,在胃酸进一步清洗消毒之前,在蛋白酶精准下刀之前,火就已经帮我们完成了第一轮的分子拆解准备。它像是提前“破壁”的加工环节,把原本结构坚固、功能复杂的蛋白质,先拷打一遍,打得它服服帖帖。

如果没有火,人类还像动物一样吃生食,那么我们的胃要更酸、消化酶要更多、消耗的能量要更高,消化过程会变得费力低效,还要时刻提防中毒风险。所以,有时候人类之所以伟大,不只是会吃,而是学会了“怎么先把东西处理成能吃的”。

人类消化的第一步是用牙齿撕开,咬断和磨碎。不过这只是一个物理过程,真正的消化战场在胃里。首先出场的是:胃蛋白酶。