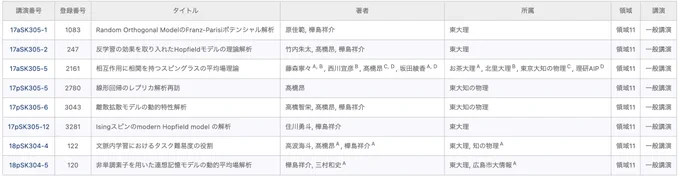

Working in StatPhys & ML, Assoc. Prof. @OchadaiNews, Team Director @RIKEN_AIP, Visiting Assoc. Prof. @tousuuken & Board of Director, Japan Stat. Soc.

Joined April 2024

- Tweets 165

- Following 427

- Followers 377

- Likes 161

市川さん(富士通)、柏村さん(東大D3)との共同研究が公開されました

arxiv.org/abs/2510.10693

AyakaSakata retweeted

指導中の博士課程の学生がイタリアのボッコーニ大学での1ヶ月の研究滞在に出発しました。ボッコーニ大はベイズ統計学の世界的拠点です。受け入れを許可いただいた先生をはじめ、彼の滞在に関してサポートいただいたすべての方に感謝します。

理研AIP情報統計動力学チームからは3本の論文がNeurIPS2025に採択されました✨

aip.riken.jp/news/neurips202…

明日は生物物理学会のシンポジウム「Integrating Measurement and Information Science: Unlocking New Frontiers in Biology」で講演します。どうぞよろしくお願いいたします🦌

AyakaSakata retweeted

【NeurIPS2025採択✨】

プレスで利用した量子化技術「Quantization Error Propagation(QEP)」がNeurIPS2025に採択されました🔥

量子化誤差を適切に伝播することで量子化誤差を大幅に下げることができます。

低ビット量子化は、正直これなしでは成り立ちません😎

nikkei.com/article/DGXZQOUC0…

こちらの論文がNeurIPS2025に採択されました👏

高波さん(東大M2)と髙橋さん(東大助教)との共同研究を公開しました。多段階Self-Distillationの解析を行い、性能を検証しています。

arxiv.org/abs/2501.16226

統計関連学会連合大会では10日午前中に「Objective perturbation型プライバシー LASSOの高次元における典型性能評価」というタイトルで話します。「統計理論一般(1)」セッションです。どうぞよろしくお願いします📈

研究室M1の藤森さんが東北大の大関研セミナーで講演する機会をいただいたので、私もついて行きました🚅西森先生とも久しぶりに議論&雑談できました😊同じ内容は物理学会でも藤森さんが発表しますのでよろしくお願いします❗️

(東北っぽい写真を撮るのを忘れました)